人工知能(AI)を用いて採用試験を行なうシステムの導入が今年になって中国で相次いで発表されました。新型コロナウイルス感染症対策のためにオンラインでの面接が広まったためだと言われています1)。人工知能は、面接案内のお知らせを自動送信するなどの雑務をこなしてくれるだけではなく、コロナ禍で得られた膨大なデータに基づく人事評価アルゴリズムを駆使して優秀な人材を見極めます。日本でも、いくつかのメガバンクが人工知能を用いた新卒採用試験を試験的に導入することを2021年に発表しました2)。

そして、北大でも、人工知能による評価を入試に導入する研究が進められています。その研究プロジェクトの中心にいるのが池田文人さん(高等教育推進機構 高等教育研究部 教授)です。池田さんは、これまで、北大が求める人物像(コンピテンシー)を具体化するなど、北大の入試のあり方に大きくかかわってきました3)。そして、現在、これまでにはない観点から人工知能を教育において利用する研究プロジェクトを進めています。誰が北大生になるべきなのかを人工知能が決める時代が近づいているのかもしれません。教育においては人工知能のどのような利用が望まれると池田さんは考えているのでしょうか。

【原 健一/CoSTEP博士研究員】

教育における人工知能の小史

池田さんは2000年に北大の入試改革に携わる専門職として北大に赴任しました。このときから池田さんは、現在進めているプロジェクトのコアとなるアイディアをすでにもっていたのですが、「正直なところ、20年前には人工知能を使って入試での評価を行なおうなんてことはまったく考えていませんでした」と述べます。

教育における人工知能の利用(AIED;Artificial Intelligence in Education)にはすでに100年ほどの歴史があります4)。その歴史の端緒にあるのがバラス・フレデリック・スキナーのティーチングマシンです。このティーチングマシンを嚆矢として、教育における人工知能の導入がさまざまなしかたで試みられました。しかし、これらの初期のマシーンは個々の学習者のニーズに即した提案を行なうなど、より「適応的」な教育ができませんでした。

池田さんも次のように述べます。「かつての人工知能は、AならばB、BならばCといったような人間の知識を法則化して、埋め込んでできる感じでした。しかし、それだと限界があり、教育における人工知能のプロジェクトは頓挫してしまったという歴史があります。」

こうした初期の限界を乗り越えて、個別的状況に応じた学習支援を行なうための「知的学習支援システム(ITS;intelligent tutoring systems)」の開発が進められます。AIEDの歴史において最も長い歴史をもつのがこのITSの開発であり、Mathia、Assistments、altaといったさまざまなITSが21世紀に入ってから開発されました。

ところが、池田さんが目指す人工知能の教育の利用にとって、これらは十分なものではありませんでした。というのは、池田さんは、これまでなかった独自の役割をAIEDにおいて人工知能に担わせようとしているからです。

深層学習と人間の直感

では、池田さんは、試験において人工知能をどのように活用しようとしているのでしょうか。そのことを見る前に、池田さんを今の研究プロジェクトに向かわせた技術的革新に触れておきましょう。池田さんが北大に赴任してから20年の間に人工知能は「第三次AIブーム」と呼ばれるムーブメントの中で大きく進展しました。特に「深層学習(ディープラーニング)」という仕組みが導入されることで大きな飛躍を遂げました。

深層学習においては、大量のデータがものすごい速度で処理されます。すると、ある判断や評価を人工知能が下した際に、その判断や評価の根拠を人間によるデータの処理では把握し切れないところが出てきます。このように、人工知能による判断のプロセスが私たちによって把握しきれなくなる現象は「ブラックボックス化」と呼ばれます5)。

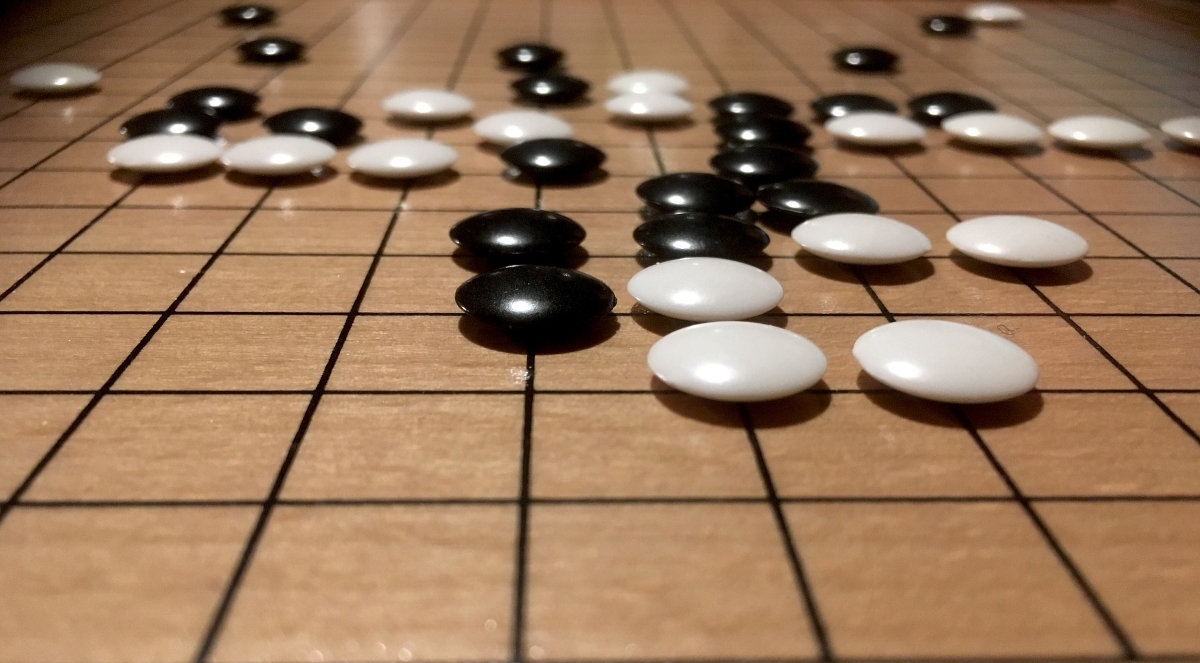

例えば、「アルファGo」という囲碁に特化した人工知能が第三次AIブームでは注目を集めました。アルファGoは、大量の対局データを超速で処理することにより、ベストな一手を提示します。しかし、処理されるデータがあまりにも多いため、「人工知能がどのようにして意思決定に至ったかはもはや透明ではなく、人間はその意思決定について十分に説明することができない6)」という現象が起こります。人工知能が犯罪予測などの社会的に影響力をもつ判断を下すこともあることを踏まえると、このブラックボックス化は大きな問題であり、人工知能の利用に対する懸念には、このブラックボックス化に由来するものが多く見られます。

しかし、池田さんは、このブラックボックス化が人工知能による評価では重要だと述べます。「これまでのコンピュータには、人間の推論を法則化したものが埋め込まれていました。それに対して、ディープラーニングという仕組みに基づいた人工知能は、明文化できない過程が学習のプロセスに関与していて、これは直感知と同様のものとしてとらえられるかもしれません。」

人間には、推論を積み重ねて判断する場合と、推論を経ずに直感で物事を処理する場合があります。この後者の直感的判断が従来の人工知能には難しかったのです。しかし、深層学習に基づいた大量のデータ処理を直感的な判断と同様のものととらえることができるならば、現在の人工知能にも人間的な直観(に似たもの)はできるかもしれません。このブラックボックスを直感知のあり方と重ね合わせるという発想が池田さんを今の研究プロジェクトへと導きました。

人工知能と教育の未来像~問いを評価する人工知能へ~

では、深層学習による人工知能の進展を通じて、池田さんはどのようなAIEDを生み出そうとしているのでしょうか。実のところ、現在の研究プロジェクトのアイディアは北大着任以前のある経験に由来します。池田さんは北大に着任する以前、株式会社NTTデータの研究員でした。当時、NTTデータには一万人くらいのシステム・エンジニア(SE)がいました。SEはトラブルの際にヘルプデスクにメールで問い合わせます。池田さんは、「回答の質を向上させて欲しい」という依頼を受け、SEの質問に対する回答を分析しました。ところが、回答の内容に差はありませんでした。

池田さんは発想を転換します。回答ではなく、SEが出した質問を分析したのです。すると、こちらには有意な差が見つかりました。回答が役に立たなかったと答えたSEの質問には「背景になる情報が少なかった」のです。つまり、トラブルに至った経緯などの文脈をしっかりと説明した質問に対して、満足度の高い回答が与えられていることが多かったのです。

この結果を通じて、池田さんはあることに気づきます。「新入社員が400人いるような大企業で、ほとんどが修士課程を出ている院生を採用していたんですけど、よくよく考えてみたら、質問の仕方って教わったことがない。しかし、質問の仕方をきちんと教えてきたほうが、社会に出てからは役に立つんじゃないかって思ったんです。その時に、たまたま、北大で入試関係の研究職の公募があって、質問を評価する入試をしたいということで応募したんです。」

つまり、問いに対する答えではなく、ひとが提示する質問や問いを評価するというアイディア。これこそが、池田さんが現在思い描いている教育における人工知能の利用法です。北大に着任した当初から、池田さんは、答えではなく、問いを評価することがこれからの入試では大切になると主張してきました。しかし、「それは面白い!」とはじめはみんな反応してくれるものの、先述の技術的な限界などによって、そのような入試は実現されませんでした。

それから20年の時が経ち、人工知能は先述の大きな進展を遂げました。「人間は質問や問いのよさを直感的に判断している面があるように思います。これまで、人工知能が質問や問いを評価することは難しかったのですが、ディープラーニングによって直観的な判断に似たことができる人工知能であれば、質問や問いのよさといったものも学習できるかもしれません。」このような発想のもと、池田さんは、問いを評価する人工知能の開発というプロジェクトを立ち上げたのです。

多様性の尊重と人工知能の機会均等

質問や問いのもつコミュニケーションを促進する力が最近になって注目されるようになってきています。会社での会議や親子のコミュニケーションなど、互いに問いかけ、その問いに答えるという営みのなかで、私たちは信頼を築き、物事を学び、そして新たなものを創造します。問いとは、そういったコミュニケーションの創造性を根っこのところで支えるものです。新たな学習指導要領の「総合的な探求の時間」の中でも、問い(リサーチクエスチョン)を立てることが一つの重要な能力として位置づけられます7)。

池田さんがいま挑戦している入試における人工知能の利用はこうした問う力の再評価と関係します。問いを評価する人工知能を開発できれば、対話を促進するために場に問いを投げかける「助言者8)」として人工知能を利用できるかもしれません。

「助言者」としての人工知能には、人々の多様性への応答が期待されてもいます。池田さんは人工知能のもつこの側面にも着目しています。「人工知能のよいところは、多様性に応じられるというところです。一人の人間が判断を下してインストラクションをしてしまうと、それはその人に特化したAIにはなるのですが、多分それだとつまらない。でもいろんな人のインストラクションを AI は聞けるので、それを全部合わせれば普遍的な判断としての集合知を AI が提示してくれるような気がします。」

とはいえ課題はあります。確かに、人工知能はデータを取り込み、それを処理する中で、差別や偏見を排した公平な判断を提案してくれるかもしれません。しかし、それと同時に、人工知能によって犯罪予測などをする時に、人種的なバイアスがある判断を人工知能が繰り返してしまい、差別が強まっていくのではないかといった懸念が表明されてもいます9)。

池田さんもこのような課題については次のように述べています。「人工知能に対する機会均等がないといけませんね。偏った人たちしか AIにアクセスできないとしたら、そこから出てくる判断も偏ったものになります。そういったことは、AI の問題というよりはむしろ私たち人間の問題のような気がします。そういった意味では、やはり、AIを教育の中で使っていこうと思うのであれば 、AI に接する機会均等を考慮しなければならないと思います。」

「AIに対する機会均等」という課題を通じて見えてくるのは、人工知能の利用においては、それを利用する人間や社会の力が試されるということでしょう。問いを評価する人工知能の今後の研究には、こうした課題への挑戦、応答ということも期待されます。

注・参考文献・リンク:

- 日経産業新聞2021:「面接動画AIが判定」『日経産業新聞』2021年1月20日、16面.

- 北海道新聞 2021:「三菱UFJ、みずほFG メガバンク採用 AIが面接」『北海道新聞』2021年7月7日、朝刊、全道(経済)12面.

- 入試が変わる! 北大が変える! 北海道大学入試改革フォーラム2017(2017年5月29日)https://costep.open-ed.hokudai.ac.jp/like_hokudai/article/7039

- ウェイン・ホルムス, マヤ・ビアリック, チャールズ・ファデル 2020; 関口貴裕(編訳)『教育AIが変える21世紀の学び:指導と学習の新たなかたち』、北大路書房、90-107.

- ブラックボックス問題については以下を参考にした。 クーケルバーグ2020; 直江清隆他(訳)『AIの倫理学』、丸善出版、97-104.

- 同上、98.

- 河野哲也 2021:『問う方法・考える方法』、ちくまプリマ―新書、61-64.

- 「助言者」としてのAIというトピックについては以下を参照されたい。岡本慎平、稲葉振一郎 2020:「AIと統治」、稲葉振一郎、大屋 雄裕、久木田 水生、成原 慧、福田 雅樹(編)『人工知能と人間・社会』勁草書房、216-21.

- 同上、4-8.

池田文人さんを紹介しているこちらの記事もご覧ください。